如何科学地消除敏感词

0.引言

某天深夜,当你正在社交媒体激情输出观点时,突然收到系统提示:”您发布的内容包含敏感信息”——这熟悉的红色感叹号背后,藏着怎样一套精密运转的”文字安检仪”?今天我们就来拆解这个让创作者又爱又恨的敏感词过滤系统。

1. 石器时代的过滤:关键词匹配

早期的敏感词过滤简单得令人感动,就像用渔网捞鱼:

1 | # 初代过滤器的灵魂代码(伪代码,仅为演示使用) |

这种精确匹配算法在2000年代初大行其道,但很快暴露致命缺陷:

- “小黄车共享单车”被误杀

- “枪支管理法”被误杀

- “白粉(指化妆品)”被误杀

此时系统就像过度紧张的保安,看见黑色行李箱就报警。据2012年某论坛统计,这种规则导致的误判率高达37%,催生了第一代”和谐文化”——用拼音缩写(如”sq”代替”色情”)轻松绕过检测。

趣闻:当时最著名的对抗案例是用户用”弓虽”拆分”强”字,系统竟真的无法识别(战术挠头.jpg)

2. 进化之路:模糊匹配与语义分析

当简单的关键词匹配沦为笑谈,第二代系统开始引入更聪明的技术:

2.1 正则表达式升级版

1 | # 匹配变体写法 |

这种模式虽然能识别”木仓”等变体,但维护成本极高——每个新词需要人工添加数十种变体写法,堪称”程序员与用户的军备竞赛”。

2.2 语义分析登场

2015年后,NLP技术开始拯救这场混战:

- 同义词扩展:自动生成”毒品→违禁药品→白粉(非化妆品义项)”的关联网络

- 上下文判断:”射击游戏”vs”射击路人”的差异识别

- 拼音转换:先转为拼音再检测,应对谐音梗

某社交平台数据显示,引入语义分析后误判率降至12%,但用户很快找到新漏洞——emoji密码学:

🚬💊=毒品交易

🐔💃=色情服务

3. 现代武器库:机器学习与深度学习

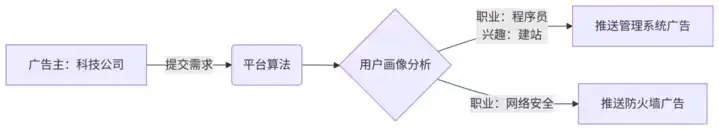

今天的敏感词系统已经武装到牙齿,其核心技术栈包括:

3.1 词向量模型

通过Word2Vec等工具,系统能理解:

- “代购”≈”走私”(相似度0.82)

- “比特币”≠”货币”(相似度0.23)

这就好比给系统安装了语义GPS,即使遇到”数字黄金”这种隐喻表述也能触发警报。

3.2 深度学习分类器

典型的双通道检测架构:

4. 攻防永动机:对抗样本与系统反制

当前沿技术相遇,出现了令人啼笑皆非的攻防战:

4.1 用户的奇招

- 通假字攻击:用”亻七”代替”他”

- 零宽度字符:插入不可见unicode字符

- 藏头诗:每行首字组合成敏感词

4.2 系统的反制

- 字形拆解:检测”⺼方攵”=”毒”的部件组合

- 语音转写:识别语音中的谐音内容

- 行为分析:频繁编辑/删除记录触发风控

最戏剧性的案例是:某用户用”🍉🐂🍺”暗示敏感事件,系统竟通过学习网络热词成功拦截(这AI怕是5G冲浪选手)。

5. 技术之外的困境

当我们在2025年审视这套系统,会发现几个根本矛盾:

- 误伤创新表达:某小说描写吸毒情节被下架,尽管主旨是禁毒

- 文化差异问题:”菊花”在中文是植物,在某些语境却是敏感词

- 审核疲劳:某平台审核员日均处理2000条内容,错误率随工作时长飙升

正如某AI伦理研究员所说:”我们建造的不仅是过滤器,更是数字时代的语言边界。”

技术冷知识:

- 中文敏感词库平均每月更新300+新词

- “疫情”一词在2020年新增42种变体写法

- 最长的敏感词是16字的特定政治口号

参考资料:

正则表达式 - Wikipedia

自然语言处理 - Wikipedia

关键词过滤 - Wikipedia

深度学习 - Wikipedia

机器学习 - Wikipedia